“听我说,谢谢你,因为有你,温暖了四季……”这是最近很流行的一首歌。熟悉的歌词,你我能聆听,也会不自觉地跟着哼唱,这是一个个带着声音的字符。但如果换成听力障碍人士呢,如果他们来“唱”,你能“听懂”吗?朱艾春老师指导的“让世界听到我——基于计算机视觉的手语识别及交互系统”项目关注聋哑人这一特殊群体,通过行为识别技术“解读”手语,让更多的人“听懂”他们的“声音”。

使命在肩,灵光闪现

新时代的青年学子不仅擅于学习,更应打牢知识功底,积蓄前进能量,又勇于探索、勇于突破,不断认识科技世界新领地,这是习近平总书记对当代青年学子的谆谆教诲。机缘巧合下,我们项目团队都是勇于创新、乐于实践的同学,大家志趣相投,相聚到了一起。

确定选题前,团队中的几位小伙伴都对深度学习中的行为识别有着浓厚的兴趣。研究领域一拍即合,但具体方向迟迟定不下来,“所求”、“所需”、“卡脖子技术”等关键词在团队成员的脑海中萦绕。

“不如我们做一个手语识别系统吧,既能很好地应用行为识别领域的相关知识,又能很好地帮助生活不便的聋哑人,还能让社会看到我们青年大学生的价值之所在”!团队的乔禹同学想起前几天遇见的一位聋哑人士,无助的比划手语却没有人能读懂,同时想到在行为识别领域中关于“连续性动作”识别层面存在着瓶颈,挑战自我的同时还能服务于社会,便灵光一闪提出了这个大胆的想法。团队成员纷纷拍手称赞。

专注于技术,落地于现实

当前,数据手套作为常见的基于传感器的设备,被广泛应用于手语识别研究。在此前的研究中,计算机的计算能力较差,实时图像处理速度受到了限制,基于数据手套的识别技术“不得不”占据主导地位。数据手套可以捕获佩戴者的手部关节信息和运动轨迹,从而获取较高的识别精度。但由于数据手套的识别方法成本高、依赖于硬件设备、用户体验较差,难以有效推广,因此,基于视觉的手语识别方法研究迫在眉睫。

基于视觉的手语识别通过摄像头捕捉手语图像和视频,利用图像处理、深度学习等技术对连续画面分析手语动作进行分析和处理获取其特征,识别出手语动作语义信息,判断其手语类别。与数据手套不同,利用图像采集设备进行手语数据采集没有过多的束缚,并且图像采集设备成本低廉、容易携带,因此,基于视觉的手语识别更有利于推广和应用,该项目顺时顺势应运而生。

同心协力迎挑战,砥砺前行克难关

项目开展过程中,“难题”不断出现,如数据集的寻找、数据的预处理、合适的训练方式,以及最后应用的落地实现等,都是项目前进路上需要克服的“拦路虎”。对此,指导老师朱艾春不辞辛劳,定时开展线上研讨会,多次为团队成员解答疑惑直至深夜,对技术瓶颈给予专业指导,成为照亮项目持续前进的灯塔。

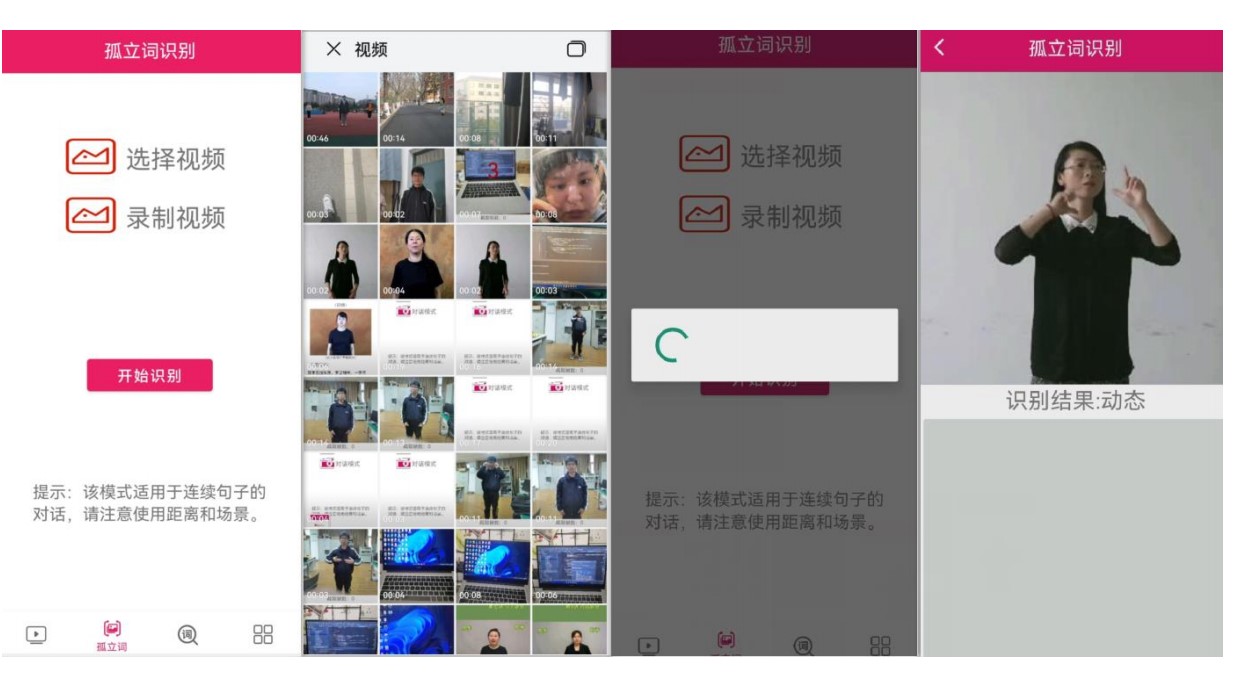

由于疫情原因,学校的科研实验关闭了,这让刚刚萌芽的项目损耗了向上生长的动力。但是方法总比困难多,从那之后学院的楼顶就成为了团队成员马柯、朱天赐等同学的另外一个“家”。一有空闲,大家就来到天台进行学术探讨,“天台实验室”见证了我们日复一日的讨论过程摩擦碰撞出的科学思想火花,终于,“孤立词建模方法”这一创新方法“迸发”出来。团队成员们为了实现所想到的思路,整宿未眠,大家仿佛被同一种精神支撑着,推动着项目前进。在团队成员的讨论声中,在科研精神的支持下,项目进度不断向前推进,并完成了第一大功能——“孤立词识别”,该功能的实现为项目后续开发“连续语句识别”功能奠定了坚实的基础。

项目答辩最终取得第二名的好成绩,不仅肯定了团队全体成员努力付出的同时,更让我们有勇气和信心面对接下来的种种挑战。目前,在项目的持续推进进程中,单个连续动作在手机APP中识别时精准度有所下降,连续语句的识别很难做到实时性等问题又浮现在团队成员眼前,但我们有信心攻克已经出现或即将出现的各种难题,使项目在特殊群体中落地,在人工智能时代为特殊群体而服务尽一分绵薄之力,让世界“读懂”他们!

作者:徐蓉蓉(计算机科学与技术学院)审核:李义丰、高辉庆